最近,我們的一位讀者向我們?cè)儐柫擞嘘P(guān)如何優(yōu)化robots.txt文件以改進(jìn)SEO的提示。Robots.txt文件告訴搜索引擎如何抓取您的網(wǎng)站,這使其成為一個(gè)非常強(qiáng)大的SEO工具。在本文中,我們將向您展示如何為SEO創(chuàng)建完美的robots.txt文件。

什么是robots.txt文件?

Robots.txt是一個(gè)文本文件,網(wǎng)站所有者可以創(chuàng)建該文件來告訴搜索引擎機(jī)器人如何在其網(wǎng)站上抓取和索引頁面。

它通常存儲(chǔ)在根目錄中,也稱為您網(wǎng)站的主文件夾。robots.txt文件的基本格式如下所示:

|

1

2

3

4

5

6

7

8

|

User-agent: [user-agent name]Disallow: [URL string not to be crawled]User-agent: [user-agent name]Allow: [URL string to be crawled]Sitemap: [URL of your XML Sitemap] |

您可以使用多行說明來允許或禁止特定URL并添加多個(gè)站點(diǎn)地圖。如果您不禁止URL,則搜索引擎機(jī)器人會(huì)假定他們可以抓取它。

以下是robots.txt示例文件的外觀:

|

1

2

3

4

5

6

|

User-Agent: *Allow: /wp-content/uploads/Disallow: /wp-content/plugins/Disallow: /wp-admin/Sitemap: https://example.com/sitemap_index.xml |

在上面的robots.txt示例中,我們?cè)试S搜索引擎在我們的WordPress上傳文件夾中抓取和索引文件。

之后,我們禁止搜索機(jī)器人抓取插件和索引插件以及WordPress管理員文件夾。

最后,我們提供了XML站點(diǎn)地圖的URL

你需要一個(gè)針對(duì)你的WordPress網(wǎng)站的Robots.txt文件嗎?

如果您沒有robots.txt文件,那么搜索引擎仍會(huì)抓取您的網(wǎng)站并將其編入索引。但是,您將無法告訴搜索引擎他們不應(yīng)抓取哪些頁面或文件夾。

當(dāng)您第一次創(chuàng)建博客并且沒有大量?jī)?nèi)容時(shí),這不會(huì)產(chǎn)生太大影響。

但是,隨著您的網(wǎng)站不斷增長(zhǎng)并且您擁有大量?jī)?nèi)容,您可能希望更好地控制網(wǎng)站的抓取和編制方式。

搜索機(jī)器人每個(gè)網(wǎng)站都有一個(gè)抓取配額。

這意味著他們?cè)谂谰W(wǎng)會(huì)話期間抓取一定數(shù)量的頁面。如果他們沒有完成對(duì)您網(wǎng)站上的所有網(wǎng)頁的抓取,那么他們將返回并在下一個(gè)會(huì)話中繼續(xù)抓取。

這可能會(huì)降低您的網(wǎng)站索引速度。

您可以通過禁止搜索機(jī)器人嘗試抓取不必要的頁面(如WordPress管理頁面,插件文件和主題文件夾)來解決此問題。

通過禁止不必要的頁面,您可以保存爬網(wǎng)配額。這有助于搜索引擎抓取您網(wǎng)站上的更多網(wǎng)頁,并盡快為其編制索引。

使用robots.txt文件的另一個(gè)好理由是,您希望阻止搜索引擎索引您網(wǎng)站上的帖子或頁面。

這不是向公眾隱藏內(nèi)容的最安全方式,但它可以幫助您防止它們出現(xiàn)在搜索結(jié)果中。

什么是理想的Robots.txt文件應(yīng)該是什么樣的?

許多流行的博客使用非常簡(jiǎn)單的robots.txt文件。它們的內(nèi)容可能會(huì)有所不同,具體取決于特定網(wǎng)站的需求:

|

1

2

3

4

5

|

User-agent: *Disallow: Sitemap: http://www.example.com/post-sitemap.xmlSitemap: http://www.example.com/page-sitemap.xml |

此robots.txt文件允許所有機(jī)器人索引所有內(nèi)容,并為其提供指向網(wǎng)站的XML站點(diǎn)地圖的鏈接。

對(duì)于WordPress網(wǎng)站,我們建議在robots.txt文件中使用以下規(guī)則:

|

1

2

3

4

5

6

7

8

9

|

User-Agent: *Allow: /wp-content/uploads/Disallow: /wp-content/plugins/Disallow: /wp-admin/Disallow: /readme.htmlDisallow: /refer/Sitemap: http://www.example.com/post-sitemap.xmlSitemap: http://www.example.com/page-sitemap.xml |

這告訴搜索機(jī)器人索引所有WordPress圖像和文件。不允許機(jī)器人搜索索引WordPress插件文件,WordPress管理區(qū)域,WordPress自述文件。

通過將站點(diǎn)地圖添加到robots.txt文件,您可以輕松地讓百度和Google機(jī)器人找到您網(wǎng)站上的所有網(wǎng)頁。

既然你知道了一個(gè)理想的robots.txt文件是什么樣子,那么讓我們來看看你如何在WordPress中創(chuàng)建一個(gè)robots.txt文件。

如何在WordPress中創(chuàng)建Robots.txt文件?

有兩種方法可以在WordPress中創(chuàng)建robots.txt文件。您可以選擇最適合您的方法。

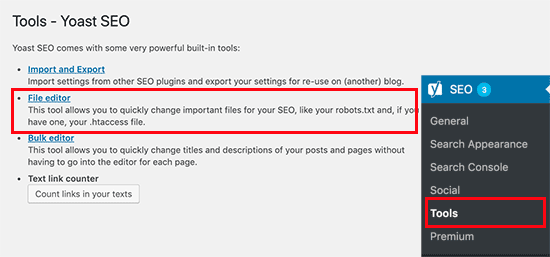

方法1:使用Yoast SEO編輯Robots.txt文件

如果你使用的是Yoast SEO插件,那么它附帶了一個(gè)robots.txt文件生成器。

您可以使用它直接從WordPress管理區(qū)域創(chuàng)建和編輯robots.txt文件。

只需轉(zhuǎn)到WordPress管理員中的SEO?工具頁面,然后單擊文件編輯器鏈接。

在下一頁,Yoast SEO頁面將顯示您現(xiàn)有的robots.txt文件。

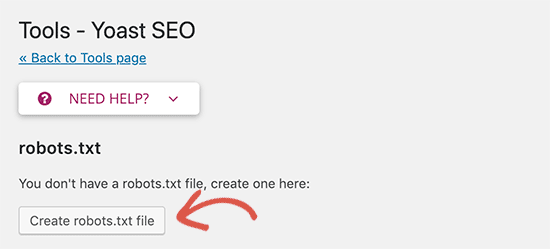

如果您沒有robots.txt文件,那么Yoast SEO將為您生成robots.txt文件。

默認(rèn)情況下,Yoast SEO的robots.txt文件生成器會(huì)將規(guī)則添加到您的robots.txt文件中:

刪除默認(rèn)文本后,您可以繼續(xù)添加自己的robots.txt規(guī)則。我們建議使用上面分享完美的robots.txt格式。

完成后,請(qǐng)不要忘記點(diǎn)擊“保存robots.txt文件”按鈕來存儲(chǔ)您的更改。

方法2.使用FTP手動(dòng)編輯Robots.txt文件

對(duì)于此方法,您將需要使用FTP客戶端 來編輯robots.txt文件。

只需使用FTP客戶端連接到您的WordPress主機(jī)帳戶即可。

進(jìn)入后,您將能夠在網(wǎng)站的根文件夾中看到robots.txt文件。

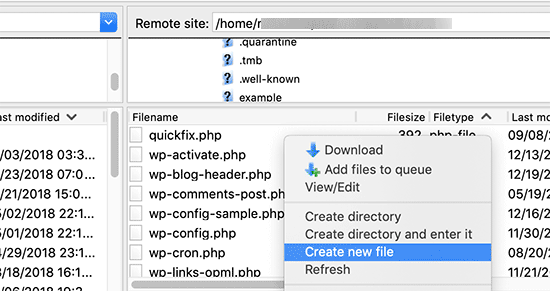

如果您沒有看到,那么您可能沒有robots.txt文件。在這種情況下,您可以繼續(xù)創(chuàng)建一個(gè)。

Robots.txt是一個(gè)純文本文件,這意味著您可以將其下載到您的計(jì)算機(jī)并使用任何純文本編輯器(如Notepad或TextEdit)進(jìn)行編輯。

保存更改后,您可以將其上傳回網(wǎng)站的根文件夾。

最后總結(jié)

優(yōu)化robots.txt文件的目的是阻止搜索引擎抓取不公開的網(wǎng)頁。例如,wp-plugins文件夾中的頁面或WordPress管理文件夾中的頁面。

我們建議您按照上述robots.txt格式為您的網(wǎng)站創(chuàng)建robots.txt文件。